El gran error de combatir los bots de noticias falsas con más IA

Facebook y Twitter están centrando sus esfuerzos contra la desinformación en sistemas automatizados de inteligencia artificial. Pero esta estrategia no basta por sí sola. Ha llegado la hora de que las redes sociales dediquen trabajo y conocimientos humanos a luchar contra la propaganda computacional

por Samuel Woolley | traducido por Ana Milutinovic

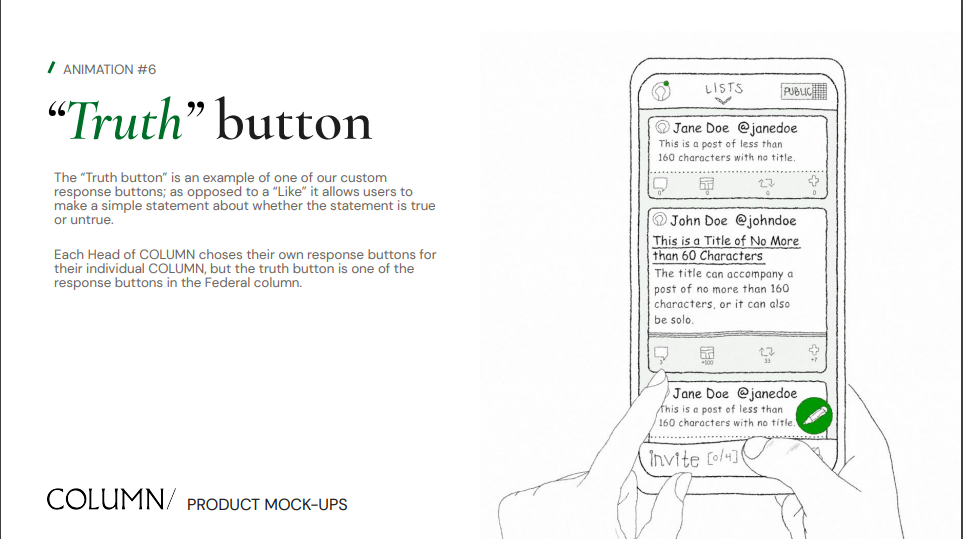

Este es un fragmento adaptado de ‘The Reality Game’ sobre cómo la próxima ola tecnológica acabará con la verdad. Se trata del último libro del profesor asistente en la Escuela de Comunicación Moody de la Universidad de Texas en Austin (EE. UU.) Samuel Woolley.

Al entrar en Twitter para ver alguna publicación popular, es común encontrar cuentas robóticas que la comentan o la recomiendan. Si se analizan un poco, se puede detectar que esas cuentas tuitean muchas veces, a menudo en un corto período de tiempo. A veces sus publicaciones venden basura o propagan virus digitales. También hay cuentas exclusivamente políticas, especialmente las de bots que responden con insultos incomprensibles a artículos de noticias o declaraciones oficiales.

Es fácil suponer que este fenómeno ha sido impulsado por la informática avanzada. De hecho, he hablado con muchas personas que creen que los algoritmos de aprendizaje automático impulsados por el aprendizaje automático o la inteligencia artificial (IA) han dado a los robots políticos la capacidad de aprender de su entorno e interactuar con las personas de manera sofisticada.

Existe una creencia generalizada de que durante los acontecimientos en los que, según algunos investigadores, los bots políticos y la desinformación han jugado un papel clave (como el referéndum de Brexit, las elecciones Trump-Clinton de 2016 y la crisis de Crimea), las herramientas de IA permitieron que los ordenadores se hicieran pasar por humanos y ayudaran a manipular el debate público.

Esa creencia ha sido alimentada por expertos y periodistas: se han publicado

historias extremadamente provocadoras sobre el surgimiento de "máquinas de propaganda de IA usadas como armas", y otras que

afirman que "la inteligencia artificial ha conquistado la democracia". Incluso mi propia investigación sobre cómo las redes sociales se utilizan para moldear la opinión pública, hackear la verdad y silenciar la protesta (algo que se conoce como "propaganda computacional") ha sido citada en algunos artículos que sugieren que nuestros señores robots ya están aquí.

Sin embargo, lo cierto es que, hasta la fecha, los mecanismos tan complejos como la inteligencia artificial han tenido un papel muy pequeño en las campañas de propaganda informática. Todas las pruebas que he visto sobre Cambridge Analytica sugieren que la empresa nunca lanzó las herramientas de marketing "psicográficas" que afirmó poseer durante las elecciones estadounidenses de 2016. Aunque la empresa aseguró que estaba capacitada para dirigirse a personas concretas con mensajes específicos basados en los perfiles de personalidad derivados de su controvertida base de datos de Facebook.

Cuando estaba en el Instituto de Internet de Oxford (Reino Unido), mis compañeros y yo analizamos si los bots de Twitter habían sido usados durante el debate sobre Brexit y cómo. Y descubrimos que, aunque se utilizaron muchos para difundir mensajes sobre la campaña Leave (a favor de la salida), la gran mayoría de las cuentas automatizadas eran muy básicas. Fueron creadas para alterar la conversación online, pero se limitaban a aumentar la cantidad de me gusta y los seguidores, para difundir enlaces y tendencias y luchar contra los troles. Dichos bots eran controlados por pequeños grupos de usuarios humanos que conocían la magia de los memes y de la viralidad, de sembrar conspiraciones online y verlas crecer. Los bots generaban tantos mensajes basura y hacían tanto ruido al adherirse a las etiquetas asociadas, que acabaron bloquean las conversaciones online. Los enlaces a artículos de noticias que mostraban a un político de una cierta manera se promocionaban a través de las cuentas falsas creadas para publicar y republicar la misma basura una y otra vez. Estas campañas fueron manejadas de forma muy clara: estos bots no fueron diseñados para manejar una conversación. Es decir, no usaban la IA.

Ya no son tontos

No obstante, hay señales de que la propaganda computacional y la desinformación habilitadas por la IA se están empezando a usar. Los hackers y otros grupos ya han empezado a probar la efectividad de los robots de IA más peligrosos en las redes sociales.

Un artículo de 2017 publicado en Gizmodo informó de que dos científicos de datos enseñaron a un sistema de inteligencia artificial a diseñar su propia campaña de phishing. El artículo detalla: "En las pruebas, el hacker artificial fue mucho mejor que sus maestros humanos, pues logró componer y distribuir más tuits de phishing que las personas, y con bastante mejor tasa de conversión."

Los robots políticos habilitados por aprendizaje automático no son los únicos que difunden contenidos problemáticos. Y las empresas de redes sociales tampoco son las únicas que crean usos o diseños problemáticos para sus plataformas. Los investigadores han descubierto que el aprendizaje automático puede contaminarse mediante ataques por envenenamiento. En estos casos, actores maliciosos influyen en los "datos de entrenamiento" para cambiar los resultados de un algoritmo dado, incluso antes de que la máquina opere públicamente.

El investigador de la Universidad George Washington (EE. UU.) Kalev Leetaru sugiere que los primeros ataques impulsados por robots de IA tal vez no se dirijan a las redes sociales, sino que se dedicarán a realizar ataques distribuidos de denegación de servicio (DDoS, por sus siglas en inglés), que consisten determinados servidores web con tráfico hasta deshabilitarlos.

Estos esfuerzos no están orientados a ayudar a las organizaciones de noticias a examinar el montón de contenido y pistas que reciben cada día para ayudar a sus periodistas con pocos recursos insuficientes a hacer mejor su mejor. En lugar de eso, están ayudando a una empresa multimillonaria a mantener limpia su propia casa a ‘post hoc’.

Leetaru escribe: "Imaginemos por un momento que el control de una botnet reside en un sistema de aprendizaje profundo y que dicho algoritmo de IA tiene un control completo sobre cada botón y cada detalle de esa botnet. También le hemos dado acceso a la información en tiempo real del estado global de internet de los principales proveedores de ciberseguridad y control de todo el mundo para que, cada segundo, pueda observar cómo la víctima y el resto de internet responden al ataque. Quizás todo esto ocurra después de que el algoritmo haya pasado varias semanas monitorizando cada detalle de su objetivo para comprender la totalidad y el matiz de sus patrones y comportamientos de tráfico y buscar en sus capas externas de defensa".

Más allá de la defensa

En abril de 2018, Mark Zuckerberg compareció ante el Congreso de EE. UU. por su mala gestión de la información de los usuarios durante las elecciones estadounidenses de 2016. En su testimonio dividido en dos partes, el CEO de Facebook mencionó el término inteligencia artificial más de 30 veces, sugiriendo que la IA sería la solución al problema de la desinformación digital con programas que combatirían el gran volumen de la propaganda computacional. Predijo que en la próxima década, la IA sería el salvador de los problemas de escala masiva a los que Facebook y otras empresas se enfrentan cuando luchan contra la propagación global del contenido basura y la manipulación.

Entonces, ¿hay alguna manera de usar IA o los bots automatizados para abordar la manipulación de la opinión pública online? ¿Podremos usar la IA para luchar contra la IA?

El Observatorio de Redes Sociales de la Universidad de Indiana (EE. UU.)

ha creado herramientas públicas que usan el aprendizaje automático para detectar bots mediante el análisis de 1.200 características para determinar si se trata de un humano o un bot.

En un comunicado de 2018, la directora de Producto de Facebook, Tessa Lyons, aseguró: "El aprendizaje automático nos ayuda a identificar las publicaciones desacreditadas duplicadas. Por ejemplo, un verificador de hechos en Francia desmintió la afirmación de que era posible salvar a una persona que sufre un derrame cerebral pinchándole el dedo con una aguja y extrayéndole sangre. Nos permitió identificar más de 20 dominios y más de 1.400 enlaces que difundían esa misma afirmación".

En esos casos, las empresas de redes sociales pueden aprovechar el aprendizaje automático para recoger e incluso verificar hechos en todo el mundo y usar sus correcciones basadas en pruebas para marcar el contenido falso.

Sin embargo, existe un gran debate en la comunidad académica sobre si la identificación pasiva de información potencialmente falsa resulta realmente efectiva para los usuarios.

Algunos investigadores sugieren que los esfuerzos de verificación de hechos tanto online como offline actuales no son demasiado eficaces. A principios de 2019, el sitio web de verificación de hechos Snopes, que se había asociado con Facebook en sus esfuerzos de corrección,

rompió dicha asociación. En una

entrevista con el Instituto Poynter, el vicepresidente de Operaciones de Snopes, Vinny Green, explicó: "No parece que nos estemos esforzando por lograr que la verificación de hechos de terceros resulte más práctica para los editores, más bien parece que nos esforzamos para que todo sea más fácil para Facebook".

Las organizaciones como Facebook siguen confiando en agentes pequeños, y generalmente sin ánimo de lucro, para examinar el contenido. Pero estos agentes suelen recibir los artículos o vídeos potencialmente falsos sin información de contexto que indique cómo o por qué se identificaron como problemáticos en primer lugar.

Queda claro que estos esfuerzos no están orientados a ayudar a las organizaciones de noticias a examinar el montón de contenido y pistas que reciben cada día para ayudar a sus periodistas con pocos recursos insuficientes a hacer mejor su mejor. En lugar de eso, están ayudando a una empresa multimillonaria a mantener limpia su propia casa a post hoc. Es hora de que Facebook se responsabilice internamente de la verificación de datos, en vez de delegar la tarea en otros grupos. Facebook y otras compañías de redes sociales también deben dejar de depender de las verificaciones de hechos a posteriori, es decir, después de que un artículo falso se haya vuelto viral. Estas compañías deben desarrollar algún tipo de sistema de alerta temprana para la propaganda computacional.

Facebook, Google y otras compañías similares emplean a personas para encontrar y eliminar contenidos violentos o con información sobre grupos terroristas. Sin embargo, son mucho menos entusiastas en sus esfuerzos por deshacerse de la desinformación. La gran cantidad de diferentes contextos en los que la información falsa fluye online, en todas partes, desde las elecciones en India hasta un importante acontecimiento deportivo en Sudáfrica, hace que a la IA le cueste mucho operar por su cuenta, sin conocimientos humanos. En los próximos meses y años hará falta emplear a hordas de personas en todo el mundo para examinar las cantidades masivas de contenido de manera efectiva en las innumerables circunstancias que surgirán.

Simplemente no hay una solución fácil al problema de la propaganda computacional en las redes sociales. Pero, son las empresas quienes tienen la responsabilidad encontrar una manera de solucionarlo. Hasta ahora, parece que Facebook está mucho más centrado en sus relaciones públicas que en regular el flujo de propaganda computacional o contenido gráfico.

Según The Verge, la compañía dedica más tiempo a celebrar públicamente sus esfuerzos para deshacerse de contenidos violentos o insultantes que a revisar sistemáticamente sus procesos de moderación.

Más allá de la verificación

Será una combinación de trabajo humano e inteligencia artificial la que finalmente logrará tener éxito en la lucha contra la propaganda computacional, pero no está claro cómo sucederá exactamente. La verificación de datos impulsada por la IA es solo una ruta hacia adelante. El aprendizaje automático y el aprendizaje profundo, junto con trabajadores humanos, pueden combatir la propaganda computacional, la desinformación y el acoso político de varias formas distintas.

Jigsaw, la incubadora de tecnología basada en Google, donde trabajé durante un año como investigador, diseñó y creó una herramienta de IA llamada Perspective para combatir el troleo y los discursos de odio en internet. Esta herramienta (en la que no trabajé) es una API que permite a los desarrolladores detectar el lenguaje tóxico automáticamente.

Su enfoque resulta algo controvertida porque no solo corre el riesgo de dar falsos positivos, sino que también modera el discurso. Según The

Wired, esta herramienta se entrenó con aprendizaje automático, pero cualquier herramienta de este tipo también se entrena con aportes de los trabajadores, quienes tienen sus propios prejuicios. Así que, ¿podría una herramienta creada para detectar el lenguaje racista y de odio fallar debido a un entrenamiento defectuoso?

En 2016, Facebook lanzó Deeptext, una herramienta de inteligencia artificial similar a Perspective de Google.

La compañía dice que ayudó a eliminar más de 60.000 publicaciones de odio cada semana. Sin embargo, Facebook admitió que la herramienta aún dependía de un gran grupo de moderadores humanos para deshacerse del contenido dañino. Mientras tanto, Twitter finalmente hizo algo al respecto a finales de 2017. Pero a pesar de haber empezado a frenar el contenido problemático y eliminar muchas cuentas de bots políticas, Twitter no ha dado explicaciones claras de cómo está detectando y eliminando esas cuentas. Mis colaboradores y yo seguimos encontrando redes masivas de bots en Twitter casi todos los meses.

Más allá del horizonte

No es sorprendente que un tecnólogo como Zuckerberg proponga una solución tecnológica, pero la IA por sí sola no es perfecta. El miope enfoque de los líderes tecnológicos en las soluciones informáticas refleja la misma ingenuidad y arrogancia que provocaron que Facebook y otras compañías dejaran vulnerables a sus usuarios.

Todavía no hay ejércitos de robots inteligentes que trabajen para manipular la opinión pública durante unas elecciones. ¿Los habrá en el futuro? Quizás. Pero es importante tener en cuenta que incluso los ejércitos de robots políticos más inteligentes no funcionan por sí solos: requerirán supervisión humana para manipular y engañar.

No se trata de una versión digital de Terminator. Las grandes mentes de la informática y de la inteligencia artificial, incluido el ganador del Premio Turing, Ed Feigenbaum y el "padrino del aprendizaje profundo", Geoffrey Hinton, se han mostrado enérgicamente en contra de los temores de que "la singularidad", la era imparable de las máquinas inteligentes, está a punto de llegar. En una encuesta de los miembros de la Asociación Americana de Inteligencia Artificial, más del 90 % dijo que la superinteligencia está "más allá del horizonte previsible". La mayoría también coincidió en que cuando los ordenadores superinteligentes finalmente llegan (si es que lo hacen), no serán una amenaza para la humanidad.

Los investigadores de la Universidad de Stanford (EE. UU.) especializados en rastrear el estado de IA

sugieren que, en la actualidad, nuestros "señores ordenadores todavía no pueden tener el sentido común ni la inteligencia general de siquiera un niño de cinco años". ¿Cómo podrían estas herramientas derrocar el dominio humano o, por ejemplo, resolver los problemas sociales tan humanos como la polarización política y la falta de pensamiento crítico? The Wall Street Journal lo

expresó en pocas palabras en 2017: "Sin humanos, la inteligencia artificial sigue siendo bastante estúpida".

Grady Booch es uno de los mejores expertos en sistemas de inteligencia artificial, y también es escéptico acerca del surgimiento de máquinas maliciosas súper inteligentes, pero por una razón diferente.

En una conferencia de TED de 2016, aseguró que "preocuparse ahora por el surgimiento de una superinteligencia resulta, en muchos sentidos, una distracción peligrosa porque el desarrollo de la informática en sí nos trae una serie de problemas humanos y sociales que deberíamos atender".

Para Booch, lo más importante es que los sistemas actuales de IA pueden hacer todo tipo de cosas asombrosas, desde conversar con humanos en lenguaje natural hasta reconocer objetos. Pero todas esas capacidades han sido definidas por humanos y codificadas bajo valores humanos. No están programados, solo se les enseña cómo deben comportarse.

El experto detalla: "En términos científicos, esto es lo que denominamos como verdad fundamental, y aquí está lo importante: al crear estas máquinas, les estamos enseñando el sentido de nuestros valores. Con ese fin, confío en la inteligencia artificial igual, si no más, que en un humano bien entrenado".

Me gustaría llevar la idea de Booch aún más lejos. Para abordar el problema de la propaganda computacional, debemos centrarnos en las personas que manejan dichas herramientas.

Sí, la tecnología en constante evolución puede automatizar la desinformación y el troleo. Puede permitir que los perpetradores operen de forma anónima y sin temor a ser descubiertos. Pero, al final, este conjunto de herramientas como modo de comunicación política se centra en lograr el objetivo humano de control. La propaganda es una invención humana, y es tan antigua como la sociedad. Como me dijo una vez un experto en robótica, no debemos temer a las máquinas que son tan inteligentes como los humanos, debemos temer a los seres humanos que no son tan inteligentes a la hora de crear sus máquinas.